‘고객 경험’은 오늘날 비즈니스의 성패를 가르는 가장 중요한 키워드 중 하나입니다. 하지만 최고의 고객 경험은 단순히 친절한 응대나 멋진 인테리어만으로 완성되지 않습니다. 고객이 우리 브랜드를 처음 인지하는 순간부터 예약, 방문, 구매, 사후 관리에 이르기까지, 모든 과정이 물 흐르듯 연결되는 하나의 완벽한 ‘여정’이 되어야 합니다. 그렇다면 이 길고 복잡한 여정의 어디가 매끄럽고 어디가 삐걱거리는지 어떻게 체계적으로 파악하고 개선할 수 있을까요?

여기에 필요한 것이 바로 고객의 여정 전체를 분해하여 강점과 약점을 파악하는 분석의 메스, ‘가치 사슬 분석(Value Chain Analysis)’입니다. 그리고 분석을 통해 쏟아져 나온 수많은 개선 아이디어들을 현실적인 실행 계획으로 바꾸어주는 나침반, ‘우선순위 매트릭스’입니다. 이 글에서는 첨부된 문서를 바탕으로 한 치과의 서비스 개선 사례를 통해, 이 두 가지 강력한 도구가 어떻게 결합하여 고객 경험을 근본적으로 혁신하는지 그 과정을 상세히 살펴보겠습니다.

가치 사슬 분석: 고객의 여정을 해부하는 분석의 메스

가치 사슬 분석이란 제품이나 서비스가 개발되어 고객에게 전달되기까지, 부가가치가 만들어지는 모든 활동의 흐름을 시간의 축으로 정리한 분석 틀입니다. 이를 통해 자사와 경쟁사의 강점과 약점을 각 단계별로 비교 분석할 수 있습니다. 제조업에서는 보통 ‘연구 개발 → 조달 → 생산 → 유통 → 판매 → A/S’와 같은 형태로 나타나지만, 서비스업에서는 고객의 경험 여정에 맞춰 유연하게 적용할 수 있습니다.

가치는 어디에서 만들어지는가?

가치 사슬 분석의 핵심은 고객이 경험하는 전체 프로세스를 MECE(Mutually Exclusive, Collectively Exhaustive; 상호 배제와 전체 포괄) 원칙에 따라, 즉 중복되거나 빠지는 단계 없이 세분화하는 것에서 시작합니다. 그리고 각 단계별로 고객에게 어떤 가치가 제공되고 있는지, 혹은 어떤 불편함이 발생하고 있는지를 냉철하게 평가합니다. 이 과정은 우리의 막연한 추측이 아닌, 고객의 입장에서 우리의 서비스를 처음부터 끝까지 다시 경험해 보는 것과 같습니다.

치과 사례로 본 서비스 가치 사슬 분석

사례에 등장하는 ’00치과’는 업계 최고 수준의 고객 서비스 체계를 구축하기 위해 가치 사슬 분석을 도입했습니다.

- 고객 여정 지도 그리기: 먼저, 치과를 방문하는 환자의 경험을 시간 순서에 따라 ‘예약 → 찾아가기/진료대기 → 진료방침 → 치료 → 지도 → 사후관리/결제’라는 6개의 핵심 단계로 나누었습니다.

- 경쟁사비교분석: 다음으로, 각 단계별로 자사(‘컨설팅 의뢰 치과’)와 경쟁사(‘고급치과’)의 서비스 수준을 상세하게 비교했습니다. 이 비교표는 마치 MRI 사진처럼 00치과의 문제점을 적나라하게 드러냈습니다.

- ‘예약’ 단계에서 경쟁사는 전화, 인터넷, 앱 등 다양한 채널을 제공하는 반면, 00치과는 현장 예약만 가능했습니다.

- ‘찾아가기/진료대기’ 단계에서는 주차 문제, 불편한 대기 좌석 등 총체적인 난국을 겪고 있었습니다.

- ‘진료방침’은 당장의 문제 해결에만 급급한 일방적인 방식이었고, ‘치료’ 분위기는 삭막했으며, ‘지도’ 단계에서는 의사의 설명이 너무 짧고 일방적이었습니다.

- ‘결제’ 단계에서도 무이자 할부 같은 고객 혜택이 전무했습니다.

이처럼 가치 사슬 분석을 통해 00치과는 고객 여정의 거의 모든 단계에서 경쟁사 대비 열위에 있다는 사실을 객관적으로 파악할 수 있었습니다.

아이디어 발상에서 실행 계획으로: 개선 과제 도출 및 우선순위화

문제점을 명확히 파악했다면, 이제 해결책을 찾을 차례입니다. 가치 사슬 분석의 가장 큰 장점은 문제점이 드러나는 동시에 개선을 위한 아이디어가 자연스럽게 도출된다는 것입니다.

약점을 강점으로 바꾸는 14가지 개선 과제

00치과는 앞서 분석한 약점들을 강점으로 전환하기 위한 14가지의 구체적인 개선 과제를 도출했습니다. 이 과제들은 앞선 가치 사슬 분석 결과와 정확히 일치합니다. 예를 들어, ‘현장에서만 가능한 예약’ 이라는 약점은 ‘앱으로 예약이 가능하게 한다’ 는 해결책으로, ‘주차 불편’ 이라는 문제는 ‘주변 주차장과 연계해 주차비 할인’ 이라는 아이디어로 이어졌습니다. 이처럼 모든 약점에 대해 하나씩 대응하는 개선안을 마련했습니다.

모든 것을 다 할 수는 없다: 우선순위 매트릭스

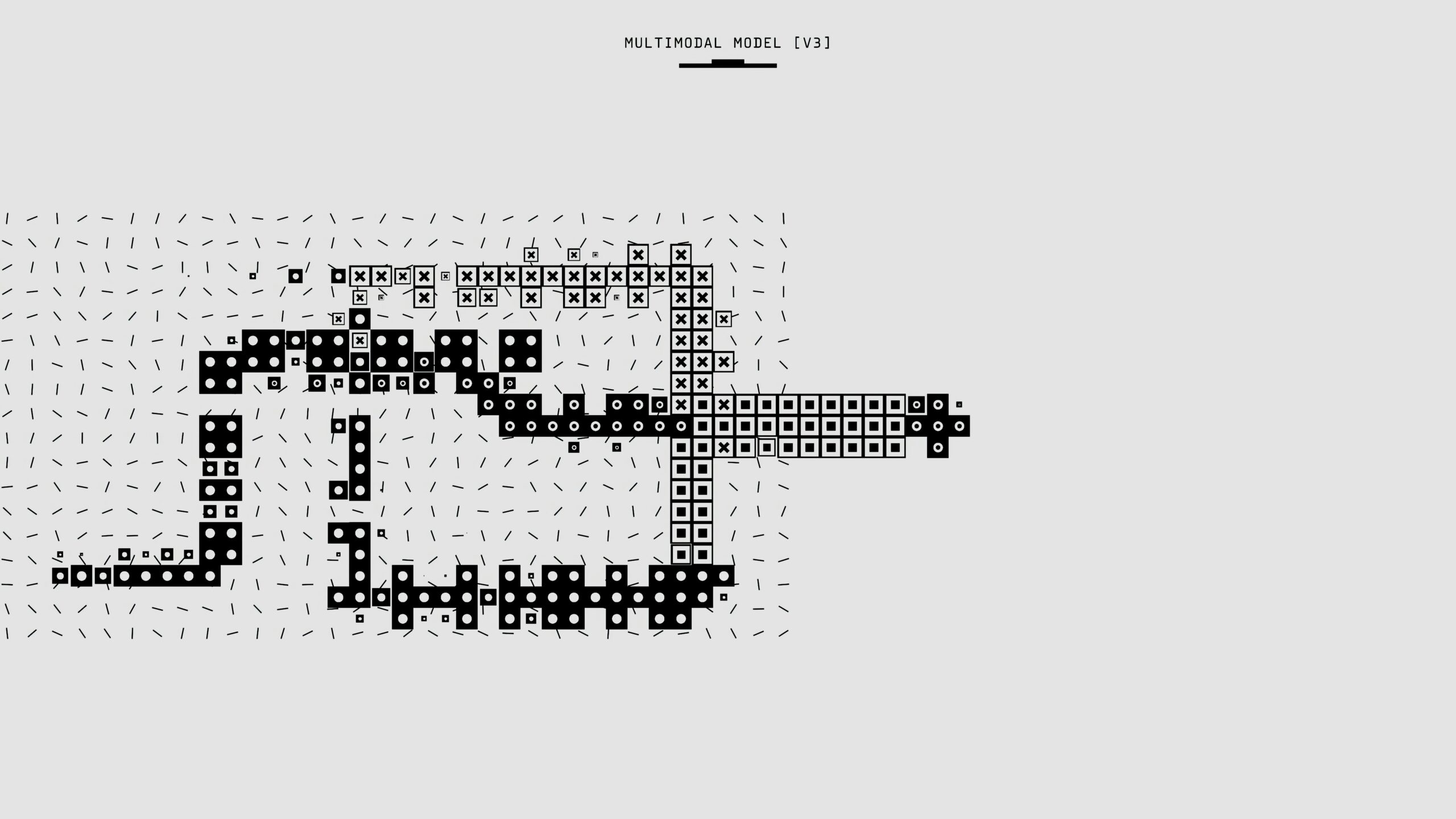

이제 14가지나 되는 훌륭한 아이디어가 생겼습니다. 하지만 문제는 모든 것을 한꺼번에 실행할 수 없다는 점입니다. 시간과 예산은 한정되어 있기 때문입니다. 이때 필요한 것이 바로 ‘선택과 집중’을 위한 도구, ‘우선순위 매트릭스’입니다. 00치과는 14개의 과제를 평가하기 위해 X축을 ‘비용(Cost)’, Y축을 ‘서비스 향상 효과(Service Improvement)’로 설정한 2×2 매트릭스를 활용했습니다.

- 1순위 (단기 개선 과제 / Quick Wins): ‘낮은 비용’으로 ‘높은 서비스 향상 효과’를 얻을 수 있는 영역입니다. 이곳에 속한 과제들은 최소의 자원으로 최대의 효과를 내는 ‘가성비’ 최고의 과제들이므로 가장 먼저 실행해야 합니다. 00치과는 의사의 설명 방식 개선(8번), 무이자 카드 확보(12번), 앱 예약 도입(1번) 등 총 8개의 과제를 여기에 배치했습니다.

- 2순위 (중장기 개선 과제 / Major Projects): ‘높은 비용’이 들지만 ‘높은 서비스 향상 효과’가 기대되는 영역입니다. 당장은 어렵더라도 장기적인 관점에서 반드시 투자해야 할 과제들입니다. 복도에 안락한 의자 도입(5번), 치료실 인테리어 개선(9번), 시술 코스 다양화(7번) 등이 여기에 해당합니다.

- 후순위 과제들: ‘낮은 비용’과 ‘낮은 효과’를 가진 과제(13, 14번)는 여력이 될 때 고려해볼 수 있습니다. 반면, ‘높은 비용’이 들지만 ‘낮은 효과’가 예상되는 과제(4번, 정교한 시스템을 통한 대기시간 단축)는 비효율적인 투자이므로 실행을 보류하거나 다른 대안을 찾는 것이 현명합니다.

이렇게 우선순위 분석을 통해 00치과는 14개의 아이디어를 ‘단기 과제(서비스 개선, 운영 시스템 개선, 시설 개선)’와 ‘중장기 과제(시설 개선)’로 명확하게 나누어 체계적인 실행 계획을 수립할 수 있었습니다.

분석과 실행, 두 날개로 비상하는 고객 경험 혁신

최고의 고객 경험을 만드는 과정은 두 개의 강력한 날개가 있어야만 비상할 수 있습니다. 첫 번째 날개는 고객의 여정 전체를 체계적으로 해부하여 모든 문제점을 남김없이 찾아내는 ‘가치 사슬 분석’이라는 날개입니다. 그리고 두 번째 날개는 분석을 통해 얻은 수많은 아이디어들 속에서 옥석을 가려내고, 현실적인 비용과 효과를 고려하여 가장 현명한 실행 순서를 정하는 ‘우선순위 매트릭스’라는 날개입니다.

00치과의 사례는 이 두 날개가 어떻게 조화롭게 작동하는지를 명확히 보여줍니다. 막연하게 “서비스를 개선하자”고 외치는 대신, 체계적인 분석을 통해 문제의 본질을 파악하고, 데이터에 기반하여 실행 계획을 수립함으로써 이들은 이제 진정한 고객 경험 혁신을 향한 구체적인 첫걸음을 내디딜 수 있게 되었습니다. 이러한 구조적인 접근법은 치과뿐만 아니라, 고객을 상대하는 모든 비즈니스에 적용될 수 있는 강력한 성공 방정식입니다.