Data Scientist는 어떻게 사고를 할까? 생각의 범위와 영역이 너무도 넓어서 우리가 그들의 사고방식을 최대한 빌린다면, 해야 될 것은 너무도 많기에 하지 말아야 할 것을 따라 하는 것이 더 수월하게 그들의 어깨 위에서 세상을 바라보는 방식일 것이다. 이 관점에서 우리가 하지 말아야 할 것들을 살펴보자.

Don’t do that

- 데이터에 결점이 없다고 가정하는 것

- 표준화하지 않는 것

- 열외의 사용자들을 배제하는 것

- 열외의 사용자들을 포함시키는 것

- 계절적 변동을 무시하는 것

- 성장을 평가할 때 전체 규모를 무시하는 것

- 지나치게 많아 의미를 잃은 데이터

- 거짓 경보를 울리는 지표

- 직접 수집한 데이터만 인정하는 배타적 태도

- 잡음(Noise)에 초점을 두는 것

상세한 설명

1. 데이터에 결점이 없다고 가정하는 것

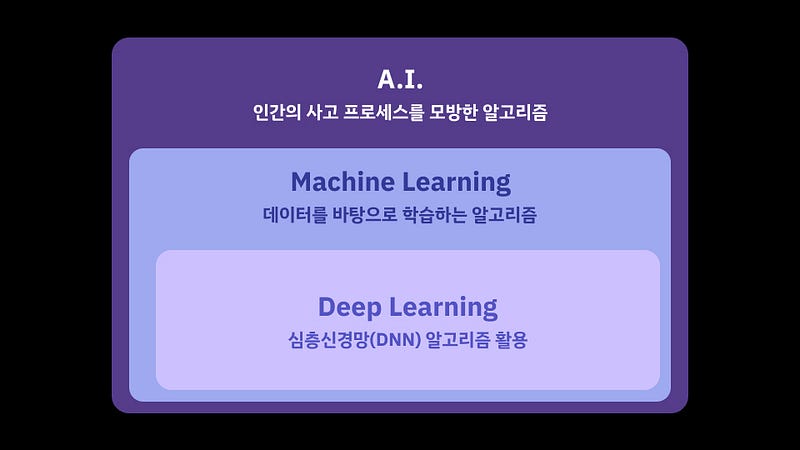

어떠한 데이터든지 간에 항상 허점은 존재하고 노이즈가 끼기 마련이다. A.I.에 들어가는 데이터를 확인해보면 데이터를 정제하는 과정에서 가장 많은 시간을 보낸다고 한다. 이를 반추해보면 데이터는 항상 기타 불순물들이 많이 낄 수밖에 없다고 가정을 하고 데이터를 보는 것이 데이터를 대하는 올바른 자세라고 할 수 있다.

2. 표준화를하지 않는 것

데이터를 표준화하지 않는다는 뜻은 기준점을 제대로 설정하지 않는 것이다. 금주에 방문한 사용자가 얼만지 비교를 하기 위해서는 전주 데이터 혹은 동년 동기 데이터를 비교하는 것이 해당 지표가 얼마나 성장했는지를 파악할 수 있는 근거가 된다. 여기서 1주일을 설정했는데, 비교기간은 2주를 설정한다 이건 말이 안 되는 짓이다.

3. 열외의 사용자들을 배제하는 것

공명 정대한 수학에서도 예외는 존재한다. 0.99999999 = 1 이라는 것이다. 비단 가장 공정하고 클리어한 수학의 세계에서도 예외가 존재하는데 분석하는 데이터에 예외가 없다. 이것은 말이 안 된다. 예외를 어떻게 볼 것인가? 특정 서비스를 천 번 이상 방문하는 사람들은 서비스의 열혈 팬일 수도 있지만 콘텐츠를 수집해가는 검색 로봇일 수도 있다. 따라서 어떤 경우든 이들을 무시하는 것은 실수일 수 있다.

4. 열외의 사용자들을 포함시키는 것

위의 내용과 연장선으로 정상치 혹은 평균치를 찾는데, 특이한 데이터를 포함한다. 이것은 실수이다. 올림픽 채점 제도에서 가장 높은 점수와 가장 낮은 점수를 배제하고 합산 점수를 매기는 경우가 있다. 이도 마찬가지이다. 하루에도 백 번 이상 서비스를 방문하는 사람들은 예상치 못했던 것을 알려줄 수도 있으므로 정성적인 관점에서는 흥미로울 수도 있지만 일반 모델(스탠더드)을 구축할 때는 도움이 되지 않는다.

5. 계절적 변동을 무시하는 것

계절이 여기서 4계절일 수 있지만, 여기서는 이벤트와 연관된 지표를 무시하는 것이라고 해석하는 것이 편하다. 가령 교육용 Smart TV 앱이 있다고 하자 올림픽 기간에 사용자가 급격하게 줄어들고 시험기간에 급격하게 늘어날 수 있다. 항상 데이터가 생성될때는 진공상태에서 생성되는 것이 아니라는 생각을 해야 한다. 씨줄과 날줄로 얽혀 천을 만들듯이 데이터 또한 이벤트 혹은 시간적 특수성에 영향을 받는다. 결국 중요한 것은 패턴을 찾아야 한다.

6. 성장을 평가할 때 전체 규모를 무시하는 것

이것도 위와 같은 맥락이다. 전체의 규모를 봐야한다. 그림을 그릴 때, 한 곳만 죽어라 그리면 전체적인 균형이 맞지 않듯이 데이터를 분석하는 과정도 마찬가지이다. 그래서 상승을 할 때, 항상 전월 대비 혹은 전주 대비 비교지표가 있고 전주에 비해서 얼마나 많은 등락을 했는지 평가를 하고 전체 누적 데이터 중에서도 분 서울 해야만 정확한 수준의 분석을 이룰 수 있다.

7. 지나치게 많아 의미를 잃은 데이터

너무 많은 종류의 데이터가 있으면 길을 잃어버린다. 발생하는 많은 데이터 중에서 가장 핵심 지표 하나를 설정하는 결정이 필요하다.

8. 거짓 경보를 울리는 지표

거짓 경보는 위험하지 않은데 위험하다고 하거나, 좋은데 나쁘다고 경고를 하는 지표를 뜻한다. 내지는 경보를 너무 자주 울려 사람을 지치게 하거나. 측정 방식의 실수로 인해 데이터가 오염되었음에도 불구하고 좋아지는 데이터에 의심하지 않는 행동은 오해를 불러일으킨다. 경보는 아주 급박한 상황에서 빛을 발한다. 양치기 소년의 일화처럼 3번의 연속된 경보는 분석하는 자로 하여금 지치게 만들고 대수롭지 않게 문제를 파악하게 하는 악수를 두게 된다.

9. 직접 수집한 데이터만 인정하는 배타적 태도

세상에 모든 일을 한 사람이 파악할 수 없으며 데이터를 모을 수도 없다. 따라서 전반적인 경향을 파악하는데 타인이 혹은 타 기관이 분석한 데이터를 어떻게 잘 활용할 것인가도 그 사람의 능력이 된다.

10. 잡음(Noise)에 초점을 두는 것

노이즈는 노이즈다. 이것을 그냥 넘어가고, 많이 크게 되지 않게 사전 관리만 해주면 문제가 없는 상황이 된다.