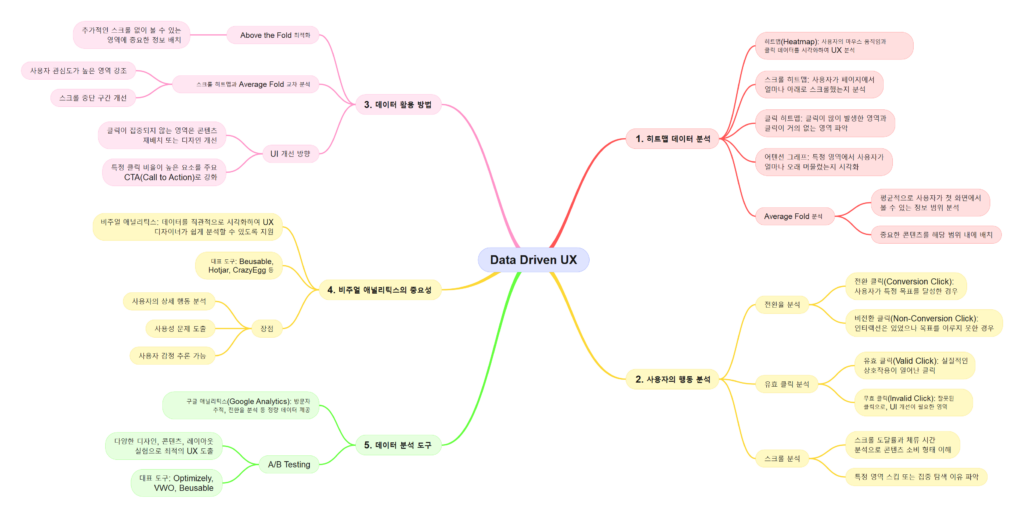

사용자 행동 데이터는 디지털 환경에서 UX를 최적화하는 핵심 자산입니다. 기술의 발전으로 데이터 분석은 더 정교해지고 있으며, AI와 머신러닝을 통해 사용자의 행동을 예측하고 맞춤형 경험을 제공하는 것이 가능해졌습니다. 그러나 데이터 활용에는 한계와 윤리적 고려사항도 존재합니다. 이 글에서는 데이터 분석 기술의 발전 방향, AI와 머신러닝을 활용한 UX 혁신, 그리고 데이터 기반 UX의 한계와 윤리적 고민을 탐구합니다.

데이터 분석 기술의 발전 방향

1. 실시간 데이터 분석

기존 데이터 분석은 과거 데이터를 기반으로 한 결과를 제공했습니다. 하지만 실시간 데이터 분석 기술은 현재 사용자의 행동과 환경을 즉각적으로 분석하고 대응할 수 있는 역량을 제공합니다.

- 예시: 전자상거래 사이트에서 사용자의 클릭 데이터를 실시간으로 분석하여 개인화된 상품 추천 제공.

2. 멀티채널 데이터 통합

현대 사용자는 여러 기기와 채널을 넘나들며 서비스를 이용합니다. 멀티채널 데이터를 통합 분석하면 사용자 여정을 전체적으로 이해할 수 있습니다.

- 활용 사례: 고객이 모바일 앱에서 검색한 상품을 데스크톱에서도 추천하는 통합 경험 제공.

3. 데이터 시각화 기술의 발전

더 복잡한 데이터를 직관적으로 표현하는 시각화 도구들이 발전하고 있습니다. 데이터는 차트와 히트맵을 넘어 3D 인터페이스와 증강현실(AR) 기술로 표현되고 있습니다.

- 예시: 마케팅 캠페인의 사용자 반응을 AR 환경에서 시각화하여 즉각적인 의사결정 지원.

AI와 머신러닝을 활용한 사용자 행동 예측

1. 행동 예측 알고리즘

AI는 과거 데이터를 학습하여 사용자의 미래 행동을 예측합니다. 이를 통해 사용자가 다음에 무엇을 할지 예상하고 경험을 맞춤화할 수 있습니다.

- 실제 사례: 넷플릭스는 머신러닝을 활용해 시청 기록을 분석하고 사용자에게 맞춤형 콘텐츠를 추천합니다.

2. 챗봇과 음성 인터페이스

AI 기반의 챗봇과 음성 인식 기술은 사용자의 요청을 실시간으로 처리하고, 개인화된 답변을 제공합니다.

- 활용 사례: 아마존 알렉사와 같은 음성 인터페이스는 사용자의 질문에 빠르게 답하고, 필요한 정보를 제공합니다.

3. 감정 분석

AI는 텍스트, 음성, 얼굴 인식 데이터를 분석하여 사용자의 감정을 파악할 수 있습니다. 이를 통해 더 감성적인 사용자 경험을 제공할 수 있습니다.

- 예시: 감정 분석 기술을 활용해 고객 서비스 센터의 응답을 사용자 감정에 맞게 조정.

데이터 기반 UX의 한계

1. 데이터의 편향성

수집된 데이터가 특정 사용자 그룹에 편향되어 있을 경우, 잘못된 분석 결과를 초래할 수 있습니다. 이는 사용자 경험을 왜곡하거나 특정 집단을 배제하는 결과를 낳을 수 있습니다.

- 해결책: 다양한 사용자 그룹의 데이터를 균형 있게 수집하고 분석.

2. 지나친 의존성

데이터 분석에만 의존하면 창의적이고 감성적인 UX 설계가 어려워질 수 있습니다. 데이터는 과거와 현재를 반영할 뿐, 사용자 니즈의 변화를 예측하기엔 한계가 있습니다.

- 대안: 데이터와 정성적 연구(설문, 인터뷰 등)를 병행하여 통합적인 접근.

윤리적 고민과 데이터 활용

1. 사용자 데이터의 프라이버시

데이터 수집과 분석이 강화되면서 개인정보 보호 문제가 대두되고 있습니다. 사용자는 자신의 데이터가 어떻게 사용되는지 알 권리가 있습니다.

- 실질적 팁: 투명한 개인정보 정책을 제공하고, 사용자가 데이터 사용에 동의하도록 설정.

2. 데이터 남용 방지

기업은 데이터를 수익화하는 과정에서 윤리적 경계를 넘어서는 경우가 있습니다. 이는 사용자 신뢰를 무너뜨릴 수 있습니다.

- 예시: 페이스북이 사용자 데이터를 부적절하게 활용하여 신뢰 문제가 발생한 사례.

3. AI의 결정 투명성

AI가 내린 결정의 과정이 불투명할 경우, 사용자는 결과를 신뢰하지 않을 수 있습니다. AI의 알고리즘은 해석 가능하고 설명 가능해야 합니다.

- 실질적 팁: AI 모델이 사용자의 데이터로 어떻게 작동하는지 명확히 설명하는 인터페이스 제공.

실제 사례와 실질적 팁

사례 1: Spotify의 개인화된 플레이리스트

Spotify는 머신러닝을 활용해 사용자의 청취 데이터를 분석하고 매주 개인화된 ‘Discover Weekly’ 플레이리스트를 제공합니다. 이 기능은 사용자 만족도를 크게 향상시켰습니다.

사례 2: 아마존의 상품 추천 시스템

아마존은 실시간 데이터와 머신러닝을 결합해 사용자의 검색 기록과 구매 기록을 분석, 맞춤형 상품 추천을 제공하여 매출을 증가시켰습니다.

사례 3: Google의 감정 분석

Google의 AI 기술은 사용자의 검색 키워드와 음성 데이터를 분석해 사용자의 현재 감정에 따라 검색 결과를 최적화합니다.

결론: 데이터로 UX의 미래를 설계하라

데이터 분석 기술은 UX를 새롭게 정의하고 있습니다. AI와 머신러닝을 활용하면 사용자 행동을 예측하고, 개인화된 경험을 제공하며, 감정을 이해할 수 있습니다. 그러나 데이터 편향성과 윤리적 문제를 해결하는 동시에 기술의 한계를 인지하고 창의적인 UX 설계와 결합하는 것이 중요합니다. 지속적인 기술 발전과 윤리적 활용을 통해 데이터 기반 UX는 더욱 발전할 것입니다.